El Ray Tracing se ha convertido sin duda en el futuro del renderizado a tiempo real, especialmente cuando la rasterización no puede solventar ciertos problemas visuales y no da más de si. Pero su implementación no esta siendo fácil y es que el rendimiento no es el ideal incluso con las GPUs más avanzadas. Es aquí donde entra el siguiente paso, el Ray Tracing Coherente. ¿Qué aporta, por qué es necesario y en que consiste?

El Ray Tracing utilizado en los juegos actualmente es lo que llamamos renderizado híbrido en el que la parte coherente de la escena es renderizada haciendo uso del algoritmo de rasterización y la parte incoherente de la escena es renderizada a través del trazado de rayos, por lo que pese a lo que dicen el marketing de los diferentes compañías la era en la que los juegos se renderizan puramente a través del trazado de rayos no ha llegado.

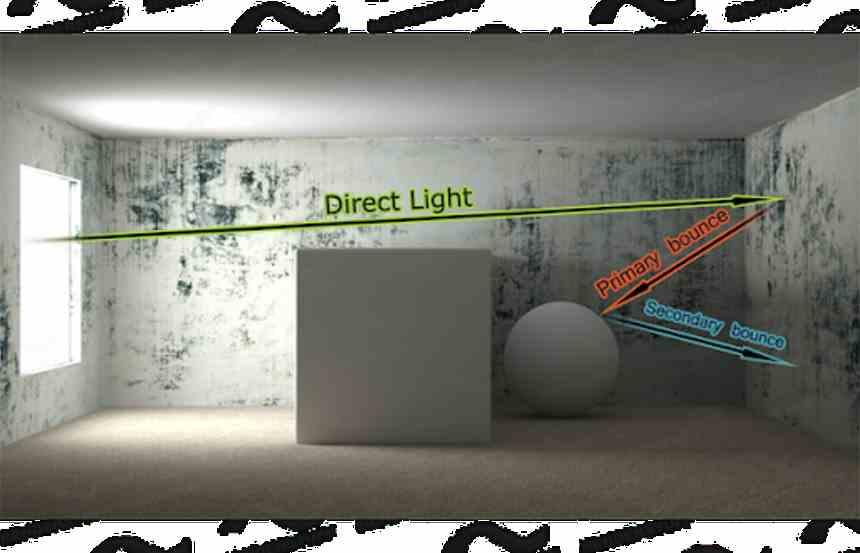

Para hacer más comprensible esta afirmación digamos que primero se renderiza la escena utilizando la rasterización ignorando por completo la iluminación indirecta, la cual es producida cuando una fuente de luz incide sobre un objeto y este refleja la luz en nuevas direcciones.

El Ray Tracing renderiza de manera más precisa, rápida y eficiente los elementos incoherentes de la escena que la rasterización, pero existe un problema de rendimiento relacionado a la hora de renderizar la parte incoherente de la escena que hace que el coste computacional sea muy alto a la hora de aplicar el trazado de rayos y ese es precisamente el próximo gran reto de empresas como NVIDIA y AMD, optimizar el rendimiento de la parte incoherente de la escena en el Ray Tracing.

Ray Tracing coherente y Ray Tracing no coherente

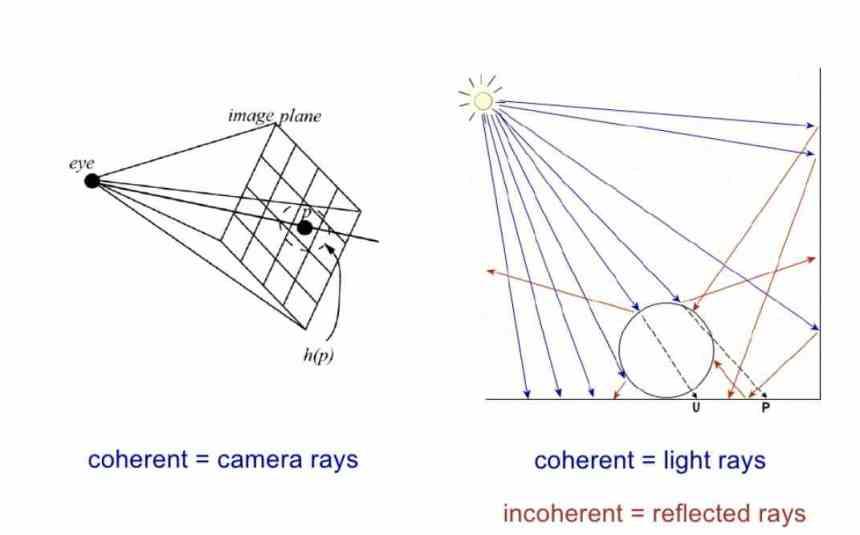

Dejemos por el momento de lado el renderizado híbrido que se utiliza en los juegos y centremos nuestra atención en el Ray Tracing puro, donde se pueden calificar los rayos de dos maneras distintas.

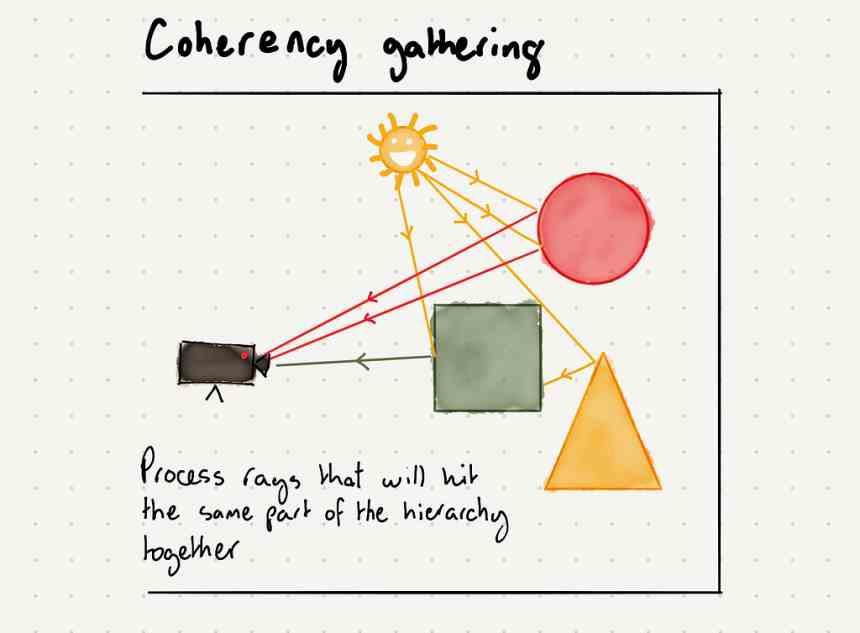

- En el Ray Tracing puro se consideran rayos coherentes los que salen de la cámara y siguen la trayectoria del view frustum de la escena, estos rayos son llamados coherentes pero no se utilizan en el renderizado híbrido.

- Los rayos incoherentes son aquellos que se producen producto del impacto de un rayo de luz sobre un objeto.

- Son rayos coherentes aquellos que salen de una fuente de luz primaria, es decir que no han sido generados por el impacto de un rayo anterior sobre el objeto.

A nivel visual si hablamos solo de iluminación directa no hay diferencia en calidad visual en renderizar una escena solo con iluminación directa entre la rasterización y el trazado de rayos, sumadle esto a que todos los motores de juego funcionan vía rasterizado y entenderéis el motivo por el cual no se utiliza el ray tracing a la hora de renderizar la parte coherente de la escena.

El rendimiento de la parte no coherente del Ray Tracing en una GPU

El problema es que, pese a que el trazado de rayos es mucho mejor a la hora de renderizar la parte incoherente de una escena que la rasterización, existe el problema que los rayos incoherentes tienen un rendimiento mucho menor que calculando los rayos coherentes de la escena.

El motivo de esta disparidad en el rendimiento es debido a que no toda la información de la escena no se encuentra en la caché de la GPU, que es a lo que acceden las unidades de intersección de rayos, con los rayos no coherentes estos no impactan sobre la misma zona de la escena y por tanto no afectan al mismo shader, lo que provoca paradas en una cantidad enorme de hilos en la GPU, provocando caidas de rendimiento en picado.

Este es un problema que en la industria del cine solucionan a través de de algoritmos de reordenación de los rayos, pero lo pueden hacer fácilmente porque conocen de antemano la posición de la cámara y por tanto pueden convertir todos los rayos incoherentes de la escena en rayos coherentes a través de un algoritmo de ordenación.

Pero a la hora de renderizar una película tienen todo el tiempo del mundo, no tienen que mostrar una imagen cada pocos milisegundos y los algoritmos de ordenación son más bien para ahorrar tiempo y con ello el coste de sus potentes granjas de renderizado, pero, la situación en los videojuegos es distinta.

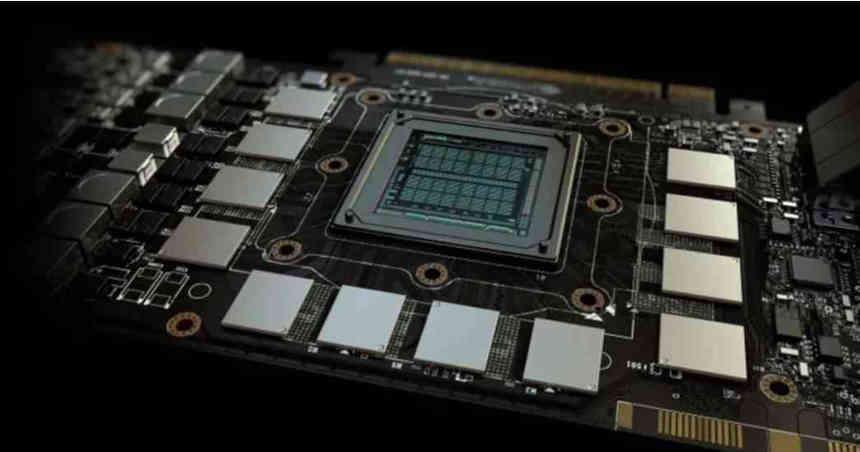

Pero en un videojuego donde cada fotograma es único no se puede hacer, es más, se necesitaría un hardware altamente potente para que ordenar los rayos de la escena no afectase la alta tasa de fotogramas de la misma, por lo que es ahora mismo el próximo gran reto a solventar por los fabricantes de GPUs y es un elemento crucial si se quiere que el Ray Tracing no se quede estancado en cuanto a rendimiento.

Las GPUs actuales no están ideadas para Ray Tracing no Coherente

Los procesadores gráficos que utilizamos en nuestros PCs se diseñaron para la rasterización, la cual es un algoritmo de renderizado que explota que se beneficia muy bien de la localización espacial y temporal de los accesos de memoria.

La mayoría de trabajos que tiene que realizar la GPU durante la rasterización tienen la particularidad que a la hora de aplicar un programa shader, especialmente durante el Píxel Shader, que los datos de los píxeles y triángulos que este procesando se comparten con sus vecinos más cercanos en la escena.

Así que hay una gran cantidad de posibilidades que si la GPU accede a los datos para un grupo de triángulos y píxeles y los recoge todos los que son cercanos en memoria hacia las cachés entonces ya tendrá los datos de los píxeles y triángulos colindantes. Por lo que los cambios han de ir de cara a explotar esa característica común de todas las GPUs.

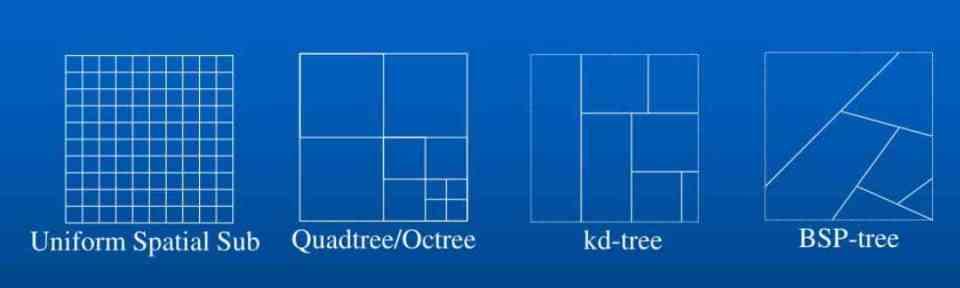

La estructura de datos espacial

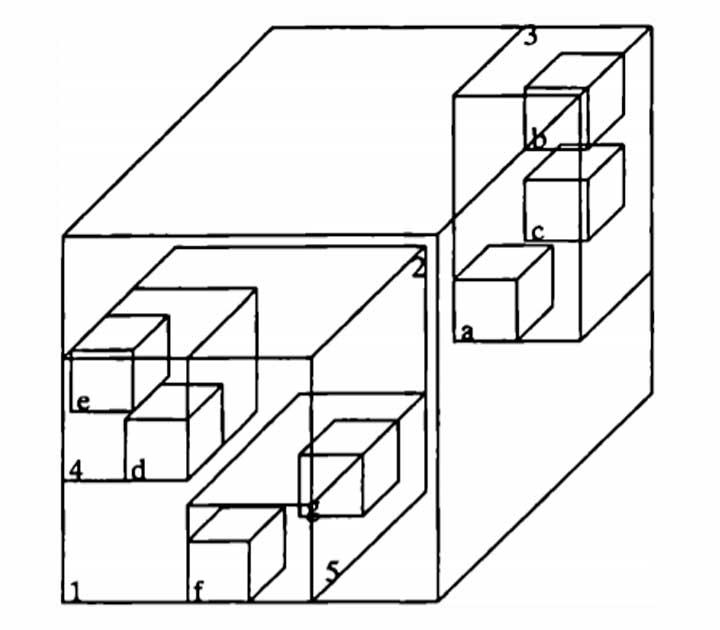

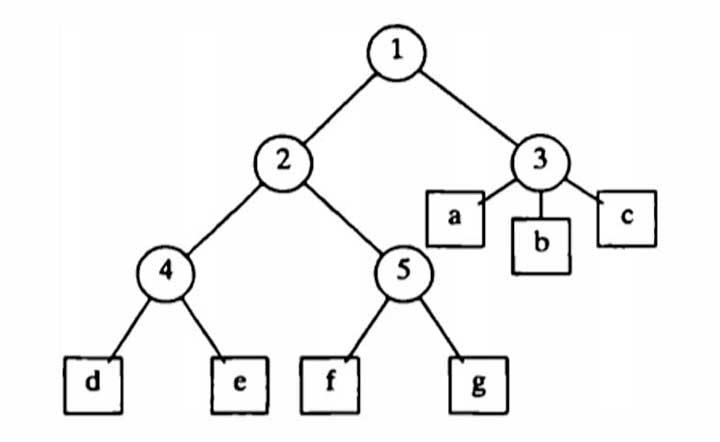

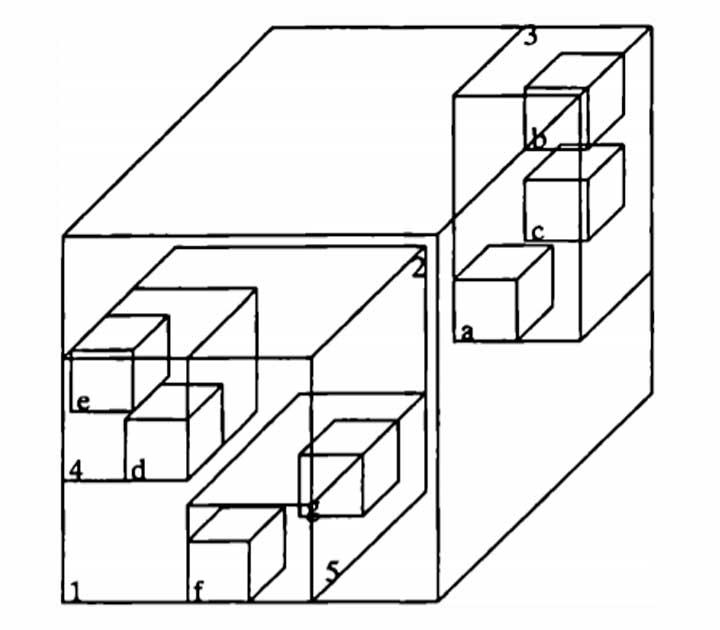

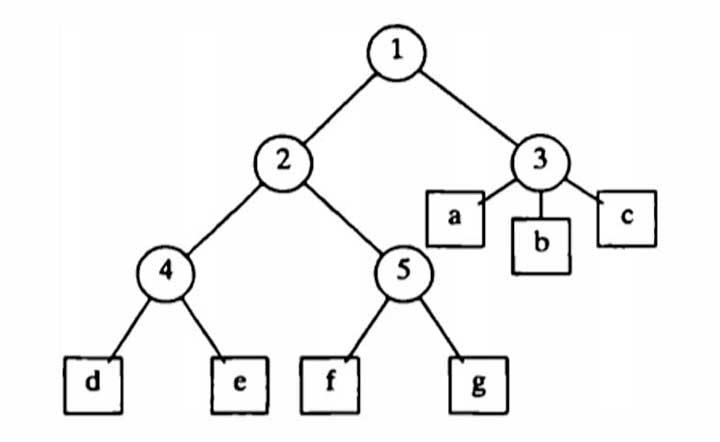

Con tal de acelerar el Ray Tracing lo que se hace es construir una estructura de datos espacial, dicha estructura no es más que el mapa de la posición de los objetos de la escena de manera ordenada.

La escena es convertida en una especie de cubo con varias sub-divisiones que indican donde están los objetos, de las que hay dos tipos:

- La escena es dividida en bloques regulares por el espacio.

- La escena es dividida en aquellas partes donde hay geometría o elementos.

En juegos se ha optado por los del segundo tipo al adoptar los BVH, especialmente por el hecho que NVIDIA tiene hardware dedicado en sus GPUs para recorrer rápidamente esta estructura de datos en árbol, pero, existen dos tipos de BVH:

- Los BVH estáticos necesitan re-construirse de nuevo después de que hayamos modificado cualquier objeto de la escena, sin embargo una vez han sido construidos aceleran el tiempo de renderizado de la escena.

- Los BVH dinámicos permiten que los objetos se actualicen individualmente, de tal manera que a la hora de reconstruir el BVH el tiempo a la hora de hacerlo sea mucho más bajo, pero a cambio aumenta el tiempo de renderizado posterior.

¿Y que importancia tiene? Si queremos ordenar los rayos según su trayectoria en la escena primero necesitamos poder tener un mapa de la misma escena que nos permita almacenar la trayectoria de los rayos.

Mapeando la trayectoria de los rayos

Una solución es hacer que los rayos pre-recorran la escena sin modificarla, solo para conocer que objetos van a afectar los diferentes rayos y cuales son los rayos que van a recorrer la escena. Una vez terminado el pre-recorrido se almacenan en un búfer de memoria los diferentes rayos que afectan a una parte de la escena en concreto aunque no tengan relación entre si.

Pese a que no hay relación directa entre los diferentes rayos de un mismo lugar si que hay relación espacial, lo que ayuda a explotar la arquitectura común de todas las GPUs a la hora de renderizar una escena con rayos no-coherentes. La idea es pre-renderizar la escena pero sin calcular los shaders que varíen los valores de color de los diferentes objetos a la hora de renderizar la escena, simplemente nos interesa conocer por cuales partes de la escena incidirá cada uno de los rayos.

Rayos pre-recorriendo la escena

Los rayos que pre-recorran la escena solo van ejecutar un shader, el Ray Generation Shader, el cual indica que ese objeto de la escena tiene la capacidad de generar un rayo de luz indirecto, en cuanto a los rayos mismos estos tienen consigo una serie de parámetros para evitar que reboten eternamente como pelotas de ping pong por toda la escena.

Para ello es necesario colocar una serie de parámetros asociados a los rayos y los objetos que serían los siguientes:

- Una constante que es el número de rebotes que puede hacer un rayo en la escena, una vez realizado esta cantidad de rebotes independientemente de cuales sean las otras condiciones dicho rayo deja de rebotar.

- Una constante en cada material que es la constante de refracción, el cual va de 0 a 1, con cada intersección el valor de energía del rayo se multiplica por la constante de refracción, cuando un rayo llega a un nivel de energía lo suficientemente bajo se descarta.

Con esto ya podemos hacer que los rayos reboten por la escena de manera preliminar, lo que ayuda a ordenar los datos, ya que con esto podemos saber en que partes de la escena incidirán los diferentes rayos. Lo cual acelerará enormemente el rendimiento, pero para ello es necesario realizar dos cambios en el hardware.

Memoria embebida para almacenar la estructura de datos espacial

Lo que nos queda ahora es poder almacenar la estructura de datos espacial al completo en una memoria lo más cercana posible al procesador, así como los datos de pre-recorrido, pero dicha estructura de datos no la podemos almacenar en las limitadas cachés de pocos Megabytes, tampoco la Infinity Caché pese a sus 128 MB sería capaz de almacenar semejante cantidad de datos.

Lo que se necesita es encontrar la forma de colocar la mayor cantidad de memoria posible cercana a la GPU, la cual sirva para almacenar la estructura de datos espacial al completo, dicha memoria no sería una caché y no formaría parte de la jerarquía de memoria del procesador, simplemente serviría para almacenar la estructura de datos espacial en su interior al completo.

Una manera manera de conseguirlo sería utilizar memoria SRAM conectada verticalmente a la GPU, pero la implementación de esta memoria podría llegar con algunos añadidos adicionales aprovechando su futura implementación en las GPUs. Aunque hay otras formas de hacerlo, incluso puede que lo hagan en forma de una nueva cache de último nivel de gran densidad.

Las próximas unidades de función fija

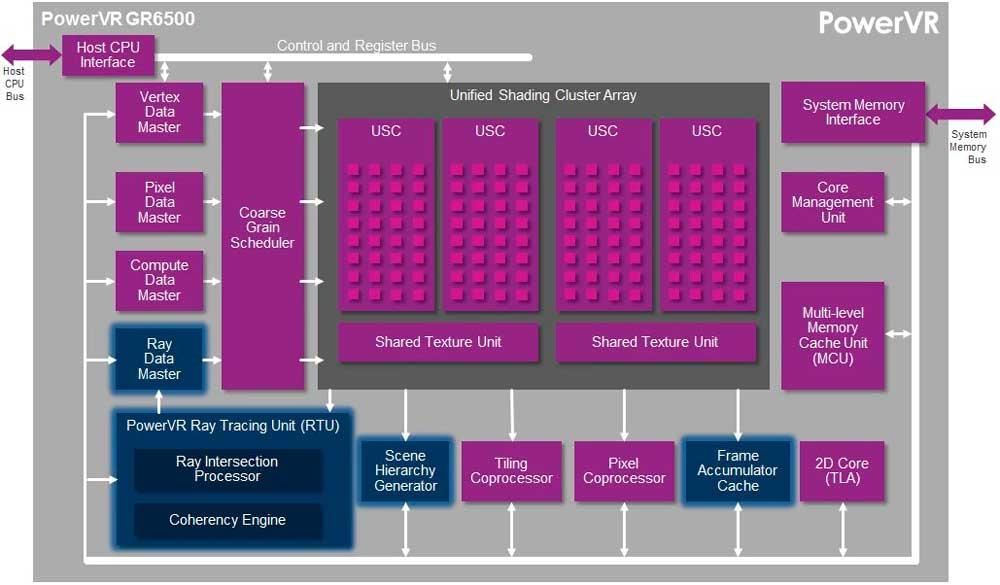

Van a ser dos, las cuales van a ser cruciales de cara a aumentar el rendimiento:

- La primera de ellas será la encargada de generar la estructura de datos espacial a través de la posición de la geometría en la escena.

- La segunda lo que hará será tomar nota de a donde incide cada rayo durante el recorrido previo a aplicar el Ray Tracing.

Ambas unidades se van a aprovechar de la enorme memoria embebida que van a incluir las GPUs para almacenar la estructura de datos espacial de la escena. Gracias a ellas veremos un gran aumento en el rendimiento en lo que Ray Tracing de refiere

Estas unidades ya se encuentran en soluciones de hardware como el PowerVR de Wizard en forma de de Scene Hierarchy Generator y Coherency Engine, su utilidad ha sido más que demostrada pero no en entornos sumamente complejos en los que será necesario la implementación de una memoria embebida.

Fuente: hardzone.es/tutoriales/rendimiento/ray-tracing-coherente/