Una de las tecnologías que más vemos repetidas a la hora de mirar las especificaciones de un monitor es el HDR, pero de un tiempo a esta parte no hemos visto la transición de lo que llamamos SDR a HDR en medios como los videojuegos, por no decir que no hemos visto una sola GPU diseñada para la HDR.

Si alguna vez te has preguntado como es posible que no hayamos visto el salto definitivo hacía la pantallas HDR dejando de lado a las SDR, seguid leyendo que descubriréis el motivo.

¿Qué es el HDR y que lo diferencia del SDR?

HDR son las siglas de alto rango dinámico, se basa en aumentar la cantidad de bits por componente RGB de los 8 bits a los 10 bits o incluso los 12 bits, pero el HDR no se basa en aumentar la crominancia y por tanto la cantidad de colores, sino la luminancia de estos, permitiendo un rango de brillo y contraste más alto por cada color y una mejor representación de estos.

No obstante, mientras que los monitores con color de 24 bits reemplazaron rápidamente a los que tenían menor definición de color, no ocurre lo mismo con los monitores basados en HDR donde todavía podemos encontrar una gran cantidad de ellos que no los soportan. Por lo que la transición no se ha llegado a dar nunca por completo.

Uno de los motivos es que el HDR es difícil promocionarlo en una pantalla que no soporte ese rango de colores, por lo que en la era del marketing a través de internet es difícil mostrar algo que se basa en la percepción visual de la gente y que no pueden ver.

Crominancia y Luminancia

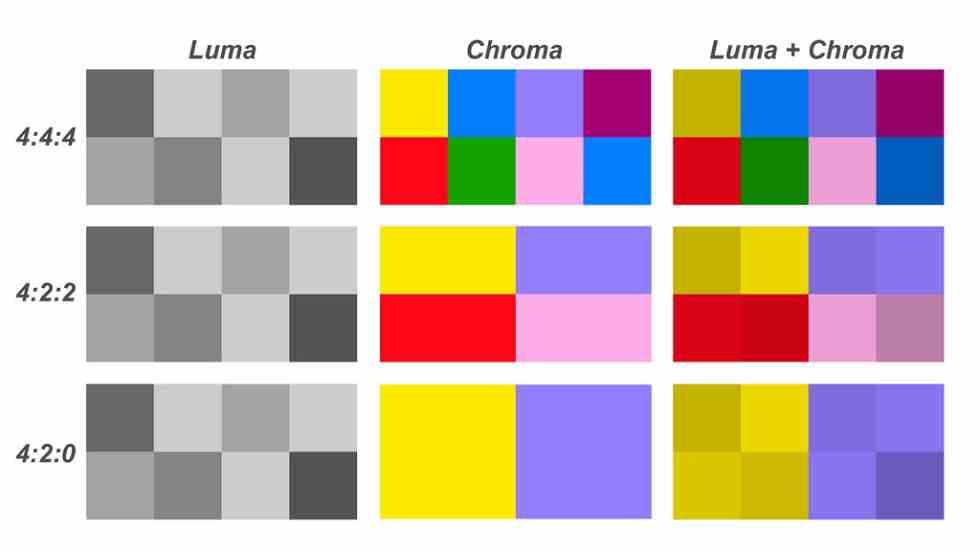

Cada píxel que se representa en pantalla es previamente almacenado en un búfer de imagen que almacena los valores de los tres componentes RGB: Rojo, Verde y Azul. Pero, la particularidad de esta forma de almacenar la información es que no solo se almacena la crominancia sino también el nivel de luminancia, que es el nivel de color o brillo de ese color.

En las televisiones antiguas en las que no había color, las imágenes se representaban por valores de luminancia y cuando vino el color ambos valores se separaron. Pero en el caso de la informática, pese a que se utilizaron pantallas con tubo de rayos catódicos durante casi tres décadas, realmente a nivel de representación interna en el búfer de imagen, ambas se representaban de la misma manera.

Durante un largo tiempo la representación máxima en color fueron los 24 bits de color, lo que da un 16.7 millones de combinaciones distintos, dicho tipo de pantallas son llamadas pantallas SDR, para diferenciarlas de las que pantallas HDR, las cuales soportan una mayor cantidad de información por píxel, con 10 e incluso hasta 12 bits por componente.

HDR y renderizado de gráficos a tiempo real

El HDR se puede representar de dos formas distintas:

- La primera de ellas es añadir más bits por componente a todos los píxeles en el búfer de imagen.

- La segunda es añadir un nuevo componente.

Ambas soluciones tienen sentido a la hora de reproducir imágenes estáticas y archivos de video, pero en el caso de las GPUs utilizadas para renderizar escenas en 3D a tiempo real la cosa que se complica, ya que esto significa que todas las unidades de la GPU que manipulan los datos de los píxeles por un lado y por otro los que transmiten esos mismos datos tengan que aumentar su precisión.

Esto tiene en consecuencia la necesidad de GPUs con mayor número de transistores y por tanto esto significan GPUs más grandes en tamaño bajo la misma potencia o menos potentes si se mantuviese el tamaño. ¿La solución tomada por los fabricantes? La segunda, esto tiene como consecuencia que el rendimiento de los juegos en modo HDR sea menor que cuando son renderizados en SDR.

Las GPUs jamás se han diseñado para el HDR sino para el SDR

Si aumentamos la cantidad de bits de información por píxel, por lógica a la hora de mover los datos en todo el renderizado nos vamos a encontrar que el ancho de banda necesario va a ser mucho mayor, lo cual se puede traducir en una bajada del rendimiento si entre la memoria que almacena los datos y la unidad que los procesa estos no se mueven a la suficiente velocidad.

Pero. el movimiento de la información es caro dentro de un procesador, sobretodo si hablamos de consumo energético, siendo este uno de los motivos por los cuales ninguna de las GPUs en los últimos años se haya preparado para funcionar de manera nativa con valores por píxel más allá de los 8 bits por componente. Por el hecho que el mayor valor de cara al diseño de nuevos procesadores la mayor premisa en rendimiento desde hace ya tiempo es la potencia por vatio.

Si al igual que otras tecnologías las GPUs se hubiesen diseñado para el HDR entonces dicha tecnología se hubiese estandarizado por completo y ahora todo el hardware y el software de PC estaría pensado para el HDR, es más, lo utilizaría todo el mundo.

Fuente: hardzone.es/tutoriales/rendimiento/hdr-sdr-transicion/